Subscribirse

1234567891011121314151617181920212223242526272829303132333435363738394041

class Compartir_Artículo { } class Opiniones_Recientes { // hace 5 días "jg-valdes" Muy buena idea Guille, gracias por compartir!! // hace 6 meses

"jg-valdes" Muy buena idea Guille, gracias por compartir!! // hace 6 meses "pedris11s" crack!!, excelente!

// hace un año

"pedris11s" crack!!, excelente!

// hace un año "yacosta738" Buen artículo, solo quería aportar algunas alternativas a nvm

1. [fnm](https://github.com/Schniz/fnm) mi herramienta favorita

2. [volta](https://volta.sh) // hace un año

"yacosta738" Buen artículo, solo quería aportar algunas alternativas a nvm

1. [fnm](https://github.com/Schniz/fnm) mi herramienta favorita

2. [volta](https://volta.sh) // hace un año "yacosta738" Hola comunidad, Les sugiero el uso de estas herramientas para el manejo de varias versiones de nodejs.

1. [fnm](https://github.com/Schniz/fnm) mi herramienta favorita

2. [volta](https://volta.sh)

3. [nvm](https://github.com/nvm-sh/nvm) // hace un año

"yacosta738" Hola comunidad, Les sugiero el uso de estas herramientas para el manejo de varias versiones de nodejs.

1. [fnm](https://github.com/Schniz/fnm) mi herramienta favorita

2. [volta](https://volta.sh)

3. [nvm](https://github.com/nvm-sh/nvm) // hace un año "eduinlight" Lo estuve usando hasta que empesé a usar asdf. Igual nvm esta bueno. // hace un año

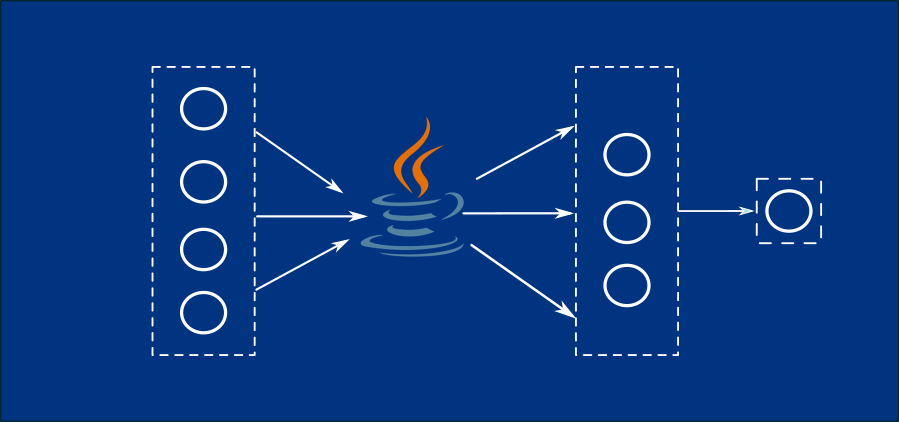

"eduinlight" Lo estuve usando hasta que empesé a usar asdf. Igual nvm esta bueno. // hace un año "cpina00" agregar que al momento de cambiar version de java, también hay que cambiar version de javac, para que se pueda desarrollar bien.

esto se hace igual que el comando de cambio de java, pero se agrega la c :D

"sudo update-alternatives --config javac

" // hace un año

"cpina00" agregar que al momento de cambiar version de java, también hay que cambiar version de javac, para que se pueda desarrollar bien.

esto se hace igual que el comando de cambio de java, pero se agrega la c :D

"sudo update-alternatives --config javac

" // hace un año "sadalsuud" gracias! me sirvió para entender los guards // hace un año

"sadalsuud" gracias! me sirvió para entender los guards // hace un año "ragnarok22" Yo usaba muchísimo los alias hasta que conocí Oh my szh y su plugin para Git.

Igual, para el que no deseé usarlo esto de los alias es buenísimo. Gracias por compartir }

"ragnarok22" Yo usaba muchísimo los alias hasta que conocí Oh my szh y su plugin para Git.

Igual, para el que no deseé usarlo esto de los alias es buenísimo. Gracias por compartir }

En el sitio actual se están utilizando cookies para mejorar su experiencia. Si desea conocer un poco más sobre el tema, puede leer las políticas de privacidad y las políticas de cookies actualizadas.